本文详细介绍了如何使用LangStudio构建“Qwen3 + 联网搜索 + RAG的聊天助手”AI应用。该AI应用通过集成实时联网搜索和RAG检索增强,为Qwen3模型提供了额外的联网搜索和特定领域知识库的能力,从而在处理用户输入的问题时,能够结合实时搜索结果和知识库提供更准确的回答。开发者可以基于该模板进行灵活扩展和二次开发,以满足特定场景的需求。

背景信息

Qwen3

作为Qwen系列最新一代的大语言模型,提供了一系列密集(Dense)和混合专家(MOE)模型。基于广泛的训练,Qwen3在推理、指令跟随、代理能力和多语言支持方面取得了突破性的进展,具有以下关键特性:

独特支持在思考模式(用于复杂逻辑推理、数学和编码)和非思考模式(用于高效通用对话)之间无缝切换,确保在各种场景下的最佳性能。

显著增强的推理能力,在数学、代码生成和常识逻辑推理方面超越了之前的QwQ(在思考模式下)和Qwen2.5指令模型(在非思考模式下)。

擅长AI能力,可以在思考和非思考模式下精确集成外部工具,在复杂的基于代理的任务中在开源模型中表现领先。可与LangStudio大模型开发平台无缝集成:结合RAG和联网搜索功能,MCP,增强知识智能获取能力。

支持100多种语言和方言,具有强大的多语言理解、推理、指令跟随和生成能力。

LangStudio

大模型&Agent应用开发平台(LangStudio)是依托阿里云PAI产品核心能力构建的面向企业级用户的一站式大模型应用开发平台产品。简化了企业级大模型应用的开发流程,同时提供了灵活的可编程能力、实时调试能力与链路追踪的能力,帮助开发者快速构建端到端的AI应用。原生兼容支持通义系列Qwen系列大模型。LangStudio专注于提供LLM全链路开发部署能力,通过一键部署到PAI-EAS,可支持发布有状态、多Agent的复杂工作流成为模型服务,并部署到生产环境提供API应用服务。

通过Qwen3与LangStudio 大模型开发平台无缝集成:结合RAG和联网搜索功能,MCP服务,增强知识智能获取能力。这样既可以发挥SOTA LLM优秀的推理能力,也可以发挥平台产品在流程编排、开发调试、权限管控等方面的优势,帮助客户高效的构建适合生产部署的智能问答应用,在效果和成本上达到最好的平衡。

具体地说,本方案具有以下优势:

精准回答:通过RAG从知识库中提取领域专业知识,结合实时网络数据补充最新信息,最大限度提升回答准确度、减少幻觉。

灵活扩展:开发者可使用自定义模型和自定义知识库,并能灵活修改应用流构成,以满足自身独有的业务需求。

高效部署:LangStudio提供可视化流程编排,支持便捷集成Qwen3先进模型能力,部署模型服务。

前提条件

开通阿里信息查询服务-IQS,注册账号并获取api_key(可通过信息查询服务-凭证管理获取)。可参考以下开通流程

开通阿里信息查询服务-IQS,详情请参见联网搜索开通说明。

通过信息查询服务-凭证管理获取IQS对应的访问凭证api_key。

LangStudio向量数据库连接支持使用Faiss或Milvus向量数据库,若您希望使用Milvus数据库,您需要先完成Milvus数据库的创建,详情请参见创建Milvus实例、实例管理。

Faiss通常用于测试环境,无需额外创建数据库即可使用。在生产环境中,建议您使用Milvus数据库,支持处理更大规模的数据。

已将RAG知识库语料上传至OSS中。

LangStudio 部署步骤

步骤一:在Model Gallery中部署Qwen3和Embedding模型

1.1 部署Qwen3大模型

进入PAI控制台 > Model Gallery,选择大语言模型场景。

根据业务场景选择部署Qwen3模型,此实践中选择Qwen3-8B。

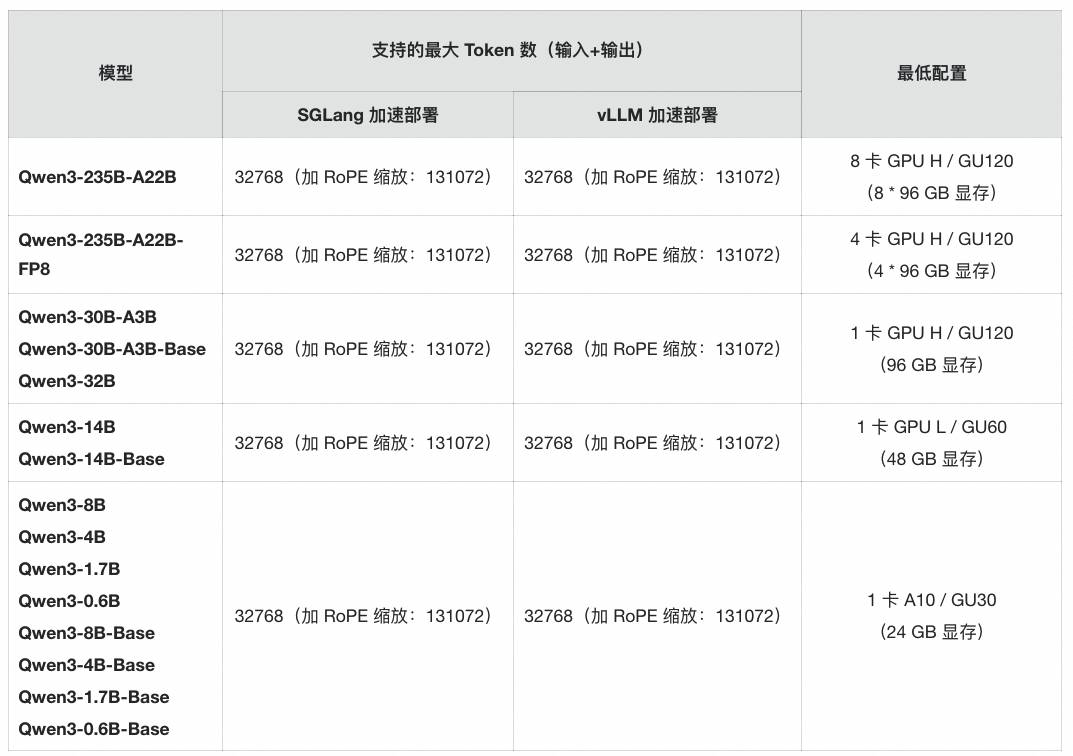

以下是Qwen3系列不同模型的建议配置信息:

以部署Qwen3-8B为例,以下状态表示部署正在进行中:

单击查看调用信息,记录部署后的服务访问地址(base_url)及API Token(api_key)。

1.2 部署Embedding模型

PAI控制台 > Model Gallery下,选择Embedding场景,部署bge-m3通用向量模型(与Qwen3兼容性最佳)。

同上步骤,记录服务地址及Token,用于后续知识库索引构建。

步骤二:在LangStudio中配置服务连接

2.1 创建连接-Qwen3模型服务

通过PAI控制台 > 进入LangStudio > 连接 > 模型服务,单击新建连接。

关键参数配置如下:

模型名称:Qwen3-8B(需与部署名称一致)。

服务提供方:选择PAI-EAS模型服务,自动显示部署后的base_url和api_key。

2.2 创建连接-Embedding模型

通过PAI控制台 > 进入LangStudio > 连接 > 模型服务

选择已部署的bge-m3模型,配置服务地址及密钥。

2.3 创建连接-联网搜索IQS

通过PAI控制台 > 进入LangStudio > 连接 > 自定义连接

填写IQS的api_key,名称设为IQS_Conn。

步骤三:构建知识库索引

进入LangStudio > 知识库索引,单击新建知识库索引。

关键参数配置如下:

数据源OSS路径:填写知识库语料的OSS路径(如

oss://my-bucket/rag-data/)。通用Embedding模型:选择步骤1.2中创建的bge-m3连接。

向量数据库:生产环境选择向量数据库-Milvus,测试环境选择Faiss。

启动索引构建,等待知识库构建任务完成。

步骤四:开发AI应用流 & 调试与优化

4.1 开发AI应用流

进入LangStudio > 应用流 > 新建应用流,模板选择 “基于Web搜索和RAG的聊天助手”。

关键节点配置:

节点-知识库检索:

索引名称:选择步骤三中创建的知识库。

Top K:建议设置为5(根据知识库规模调整)。

节点-阿里云IQS-联网搜索:

连接:选择`IQS_Conn`。

节点-大模型节点:

节点-大模型节点:模型连接:选择步骤一的Qwen3模型服务。

系统提示词模板:可自定义,例如:

基于以下知识库内容和网络搜索结果,请用中文专业且简洁地回答用户问题:

- 知识库内容:{knowledge}

- 网络搜索结果:{web_results}

-用户问题:{question}

4.2. Qwen3思考模式切换(快思考与慢思考)

Qwen3支持混合推理形态模型,同时提供“推理模式”和“非推理模式”(慢思考与快思考模式)。可通过大模型节点的启用思考参数配置模型来控制是否启用推理模式。

4.3. 调试与优化

运行测试:

输入测试问题(如“最新科创板上市规则有哪些变化?”),观察模型生成的回答质量。

运行完成后,可通过查看链路查看Tracing信息,分析Qwen3大模型整合RAG检索结果与网络搜索的结果相关性。

优化策略:

知识库增强:若回答缺乏领域细节,扩充知识库语料并重建索引。

搜索过滤:在IQS中设置time_period参数,限定搜索时间范围(如past_year)。

提示词调优:增加格式约束(如“分点回答”、“引用来源”等),提升结果可读性。

步骤五:模型服务部署与API调用

5.1 生产部署:

在LangStudio > 应用流页面单击右侧-部署,选择新建服务 > EAS资源组。

资源分配:建议至少2实例(HA),配置具备公网访问的VPC。

5.2. PAI API调用:

请求示例(Python):

```python

import requests

endpoint = "YOUR_EAS_ENDPOINT"

payload = {

"question": "解释量子计算对金融风险建模的影响",

"history": [] # 支持多轮对话

}

response = requests.post(endpoint, json=payload, headers={"Authorization": "Bearer YOUR_API_KEY"})

print(response.json()["answer"])

``` 步骤六:监控与维护

应用流监控:使用LangStudio应用流中的运行对话框,输入所需查询的问题,观察查询结果内容。

日志查看:通过PAI-EAS控制台监控服务请求量、延迟及错误率。

知识库更新:定期上传新语料到OSS,触发增量索引构建。

LLM模型升级:关注Qwen3版本更新,通过Model Gallery无缝替换新版本。

附录:常见问题

Q:网络搜索结果不相关?

A:通过“查询链路”来查看Tracing联网信息是否正确。

相关链接

通过以上步骤,您可快速使用LangStudio构建基于Qwen3的高效增强RAG+联网搜索的AI智能问题应用,满足专业场景需求。

- 本页导读 (1)

- 背景信息

- Qwen3

- LangStudio

- 前提条件

- LangStudio 部署步骤

- 步骤一:在Model Gallery中部署Qwen3和Embedding模型

- 步骤二:在LangStudio中配置服务连接

- 步骤三:构建知识库索引

- 步骤四:开发AI应用流 & 调试与优化

- 步骤五:模型服务部署与API调用

- 步骤六:监控与维护

- 附录:常见问题

- 相关链接